|

|

在上篇文章中,我們已經采集新聞信息頁的列表數據,接下來要做的操作就是從數據庫中讀取所需要采集的URL,進行頁面抓取就行

新建一個content表

不過需要注意的一點是,不能再采用采集URL這種id遞增的方法去采集,因為數據表中可能出現id斷續,比如id=9,id=11,當采集到id=10的時候,URL是空白的,這樣可能會導致采集到了空字段。

這里用到的一個技巧是數據庫的查詢語句,在我們采集完第一條數據的時候,判斷數據庫里是否還有大于此id的id編號,若有,讀取一條,查詢信息重復上面的工作。

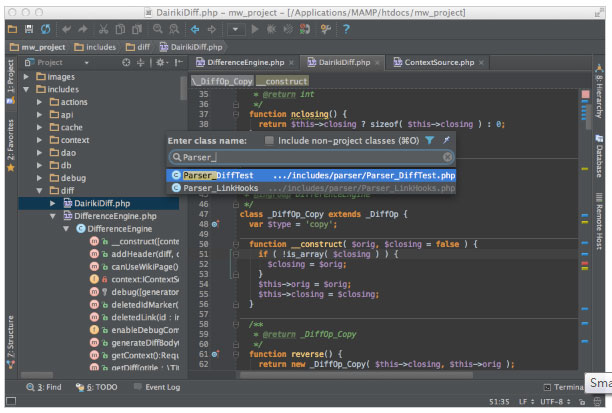

具體代碼如下:

<?php include_once("conn.php"); $id=(int)$_GET['id']; $sql="select * from list where id=$id"; $result=mysql_query($sql); $row=mysql_fetch_array($result);//取得對應的url地址 $content=file_get_contents($row['url']); $pattern="/<dd class=/"dataWrap/">(.*)<//dd>/iUs"; preg_match($pattern, $content,$info);//獲取內容存放info echo $title=$row[1]."<br/>"; echo $content=$info[0]."<hr/>"; //插入數據庫 $add="insert into content(title,content) value('$title','$content')"; mysql_query($add); $sql2="select * from list where id>$id order by id asc limit 1"; $result2=mysql_query($sql2); $row2=mysql_fetch_array($result2);//取得對應的url地址 if($row2['id']){ echo "<script>window.location='content.php?id=$row2[0]'</script>"; }?>

這樣子我們所要的新聞內容就采集入庫了,接下來只需要對數據的一些樣式進行整理就行了。

php技術:基于PHP的簡單采集數據入庫程序【續篇】,轉載需保留來源!

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。